NVIDIA เปิดตัว NIM Microservices สำหรับ Generative AI ในญี่ปุ่น ไต้หวัน ด้วยไมโครเซอร์วิสใหม่ 4 รายการที่ช่วยเร่งการปรับใช้แอปพลิเคชัน AI ขั้นสูงที่ให้มีประสิทธิภาพด้านวัฒนธรรมและภาษาขั้นสูง

โมเดลตระกูล RakutenAI 7B ที่สร้างจาก Mistral-7B ได้รับการฝึกฝนเป็นภาษาอังกฤษและชุดข้อมูลภาษาญี่ปุ่นและพร้อมใช้งานเป็นไมโครเซอร์วิส NIM สองรายการสำหรับ Chat และ Instruct โมเดลเหล่านี้ได้รับคะแนนสูงสุดในบรรดาโมเดลภาษาญี่ปุ่นแบบเปิด โดยได้คะแนนเฉลี่ยสูงสุดในเกณฑ์มาตรฐาน LM Evaling Harness ที่ดำเนินการตั้งแต่เดือนมกราคมถึงมีนาคม 2024

การฝึกอบรมโมเดลภาษาขนาดใหญ่ (LLM) ในภาษาระดับภูมิภาคจะเพิ่มประสิทธิภาพของผลลัพธ์โดยรับประกันการสื่อสารที่แม่นยำและเหมาะสมยิ่งขึ้น เนื่องจากเข้าใจและสะท้อนถึงความละเอียดอ่อนทางวัฒนธรรมและภาษาได้ดียิ่งขึ้น

แบบจำลองนี้นำเสนอประสิทธิภาพชั้นนำสำหรับการทำความเข้าใจภาษาญี่ปุ่นและภาษาจีนกลาง งานกฎหมายระดับภูมิภาค การตอบคำถาม และการแปลภาษาและการสรุปผล เมื่อเปรียบเทียบกับ LLM พื้นฐาน เช่น Llama 3

ชาติต่างๆ ทั่วโลก ตั้งแต่สิงคโปร์ สหรัฐอาหรับเอมิเรตส์ เกาหลีใต้ และสวีเดนไปจนถึงฝรั่งเศส อิตาลี และอินเดีย — กำลังลงทุนในโครงสร้างพื้นฐานด้าน AI ให้คลอบคลุม

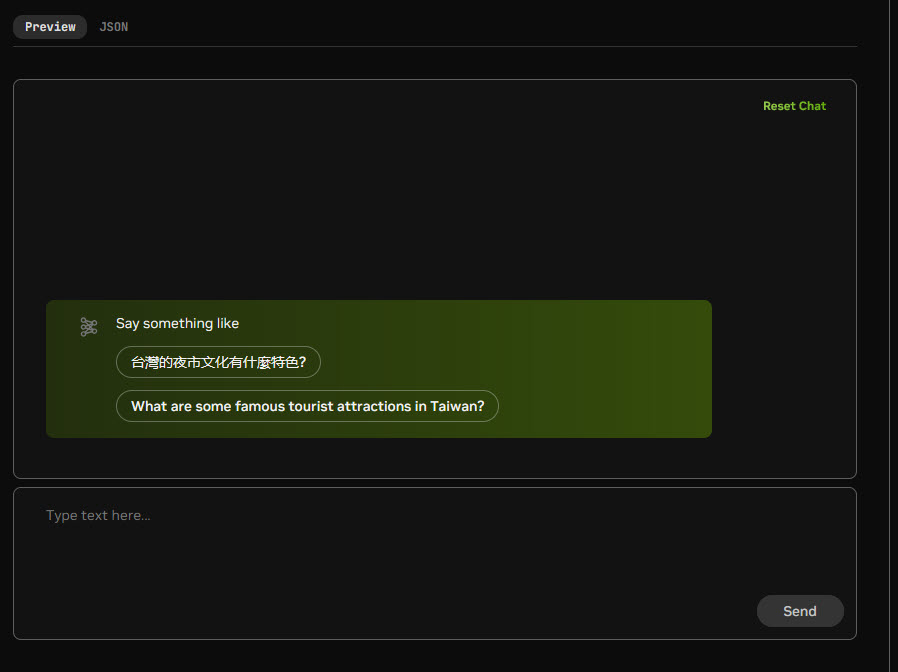

ไมโครเซอร์วิส NIM ใหม่ช่วยให้ธุรกิจ หน่วยงานภาครัฐ และมหาวิทยาลัยสามารถโฮสต์ LLM ดั้งเดิมในสภาพแวดล้อมของตนเอง ช่วยให้นักพัฒนาสามารถสร้าง copilots แชทบอท และผู้ช่วย AI ขั้นสูงได้

โมเดลตระกูล RakutenAI 7B ที่สร้างจาก Mistral-7B ได้รับการฝึกฝนเป็นภาษาอังกฤษและชุดข้อมูลภาษาญี่ปุ่นและพร้อมใช้งานเป็นไมโครเซอร์วิส NIM สองรายการสำหรับ Chat และ Instruct โมเดลเหล่านี้ได้รับคะแนนสูงสุดในบรรดาโมเดลภาษาญี่ปุ่นแบบเปิด โดยได้คะแนนเฉลี่ยสูงสุดในเกณฑ์มาตรฐาน LM Evaling Harness ที่ดำเนินการตั้งแต่เดือนมกราคมถึงมีนาคม 2024

การฝึกอบรมโมเดลภาษาขนาดใหญ่ (LLM) ในภาษาระดับภูมิภาคจะเพิ่มประสิทธิภาพของผลลัพธ์โดยรับประกันการสื่อสารที่แม่นยำและเหมาะสมยิ่งขึ้น เนื่องจากเข้าใจและสะท้อนถึงความละเอียดอ่อนทางวัฒนธรรมและภาษาได้ดียิ่งขึ้น

แบบจำลองนี้นำเสนอประสิทธิภาพชั้นนำสำหรับการทำความเข้าใจภาษาญี่ปุ่นและภาษาจีนกลาง งานกฎหมายระดับภูมิภาค การตอบคำถาม และการแปลภาษาและการสรุปผล เมื่อเปรียบเทียบกับ LLM พื้นฐาน เช่น Llama 3

ชาติต่างๆ ทั่วโลก ตั้งแต่สิงคโปร์ สหรัฐอาหรับเอมิเรตส์ เกาหลีใต้ และสวีเดนไปจนถึงฝรั่งเศส อิตาลี และอินเดีย — กำลังลงทุนในโครงสร้างพื้นฐานด้าน AI ให้คลอบคลุม

ไมโครเซอร์วิส NIM ใหม่ช่วยให้ธุรกิจ หน่วยงานภาครัฐ และมหาวิทยาลัยสามารถโฮสต์ LLM ดั้งเดิมในสภาพแวดล้อมของตนเอง ช่วยให้นักพัฒนาสามารถสร้าง copilots แชทบอท และผู้ช่วย AI ขั้นสูงได้

โมเดลตระกูล RakutenAI 7B ที่สร้างจาก Mistral-7B ได้รับการฝึกฝนเป็นภาษาอังกฤษและชุดข้อมูลภาษาญี่ปุ่นและพร้อมใช้งานเป็นไมโครเซอร์วิส NIM สองรายการสำหรับ Chat และ Instruct โมเดลเหล่านี้ได้รับคะแนนสูงสุดในบรรดาโมเดลภาษาญี่ปุ่นแบบเปิด โดยได้คะแนนเฉลี่ยสูงสุดในเกณฑ์มาตรฐาน LM Evaling Harness ที่ดำเนินการตั้งแต่เดือนมกราคมถึงมีนาคม 2024

การฝึกอบรมโมเดลภาษาขนาดใหญ่ (LLM) ในภาษาระดับภูมิภาคจะเพิ่มประสิทธิภาพของผลลัพธ์โดยรับประกันการสื่อสารที่แม่นยำและเหมาะสมยิ่งขึ้น เนื่องจากเข้าใจและสะท้อนถึงความละเอียดอ่อนทางวัฒนธรรมและภาษาได้ดียิ่งขึ้น

แบบจำลองนี้นำเสนอประสิทธิภาพชั้นนำสำหรับการทำความเข้าใจภาษาญี่ปุ่นและภาษาจีนกลาง งานกฎหมายระดับภูมิภาค การตอบคำถาม และการแปลภาษาและการสรุปผล เมื่อเปรียบเทียบกับ LLM พื้นฐาน เช่น Llama 3

ชาติต่างๆ ทั่วโลก ตั้งแต่สิงคโปร์ สหรัฐอาหรับเอมิเรตส์ เกาหลีใต้ และสวีเดนไปจนถึงฝรั่งเศส อิตาลี และอินเดีย — กำลังลงทุนในโครงสร้างพื้นฐานด้าน AI ให้คลอบคลุม

ไมโครเซอร์วิส NIM ใหม่ช่วยให้ธุรกิจ หน่วยงานภาครัฐ และมหาวิทยาลัยสามารถโฮสต์ LLM ดั้งเดิมในสภาพแวดล้อมของตนเอง ช่วยให้นักพัฒนาสามารถสร้าง copilots แชทบอท และผู้ช่วย AI ขั้นสูงได้

โมเดลตระกูล RakutenAI 7B ที่สร้างจาก Mistral-7B ได้รับการฝึกฝนเป็นภาษาอังกฤษและชุดข้อมูลภาษาญี่ปุ่นและพร้อมใช้งานเป็นไมโครเซอร์วิส NIM สองรายการสำหรับ Chat และ Instruct โมเดลเหล่านี้ได้รับคะแนนสูงสุดในบรรดาโมเดลภาษาญี่ปุ่นแบบเปิด โดยได้คะแนนเฉลี่ยสูงสุดในเกณฑ์มาตรฐาน LM Evaling Harness ที่ดำเนินการตั้งแต่เดือนมกราคมถึงมีนาคม 2024

การฝึกอบรมโมเดลภาษาขนาดใหญ่ (LLM) ในภาษาระดับภูมิภาคจะเพิ่มประสิทธิภาพของผลลัพธ์โดยรับประกันการสื่อสารที่แม่นยำและเหมาะสมยิ่งขึ้น เนื่องจากเข้าใจและสะท้อนถึงความละเอียดอ่อนทางวัฒนธรรมและภาษาได้ดียิ่งขึ้น

แบบจำลองนี้นำเสนอประสิทธิภาพชั้นนำสำหรับการทำความเข้าใจภาษาญี่ปุ่นและภาษาจีนกลาง งานกฎหมายระดับภูมิภาค การตอบคำถาม และการแปลภาษาและการสรุปผล เมื่อเปรียบเทียบกับ LLM พื้นฐาน เช่น Llama 3

ชาติต่างๆ ทั่วโลก ตั้งแต่สิงคโปร์ สหรัฐอาหรับเอมิเรตส์ เกาหลีใต้ และสวีเดนไปจนถึงฝรั่งเศส อิตาลี และอินเดีย — กำลังลงทุนในโครงสร้างพื้นฐานด้าน AI ให้คลอบคลุม

ไมโครเซอร์วิส NIM ใหม่ช่วยให้ธุรกิจ หน่วยงานภาครัฐ และมหาวิทยาลัยสามารถโฮสต์ LLM ดั้งเดิมในสภาพแวดล้อมของตนเอง ช่วยให้นักพัฒนาสามารถสร้าง copilots แชทบอท และผู้ช่วย AI ขั้นสูงได้