บทสรุปข้อมูลในงาน GTC 2024 ของ NVIDIA โดยคุณ Jensen Huang ได้ทำการประกาศเิปดตัวนวัฒกรรมเทคโนโลยีใหม่มากมายต่อไปนี้

บทสรุปข้อมูลในงาน GTC 2024 ของ NVIDIA โดยคุณ Jensen Huang ได้ทำการประกาศเิปดตัวนวัฒกรรมเทคโนโลยีใหม่มากมายต่อไปนี้

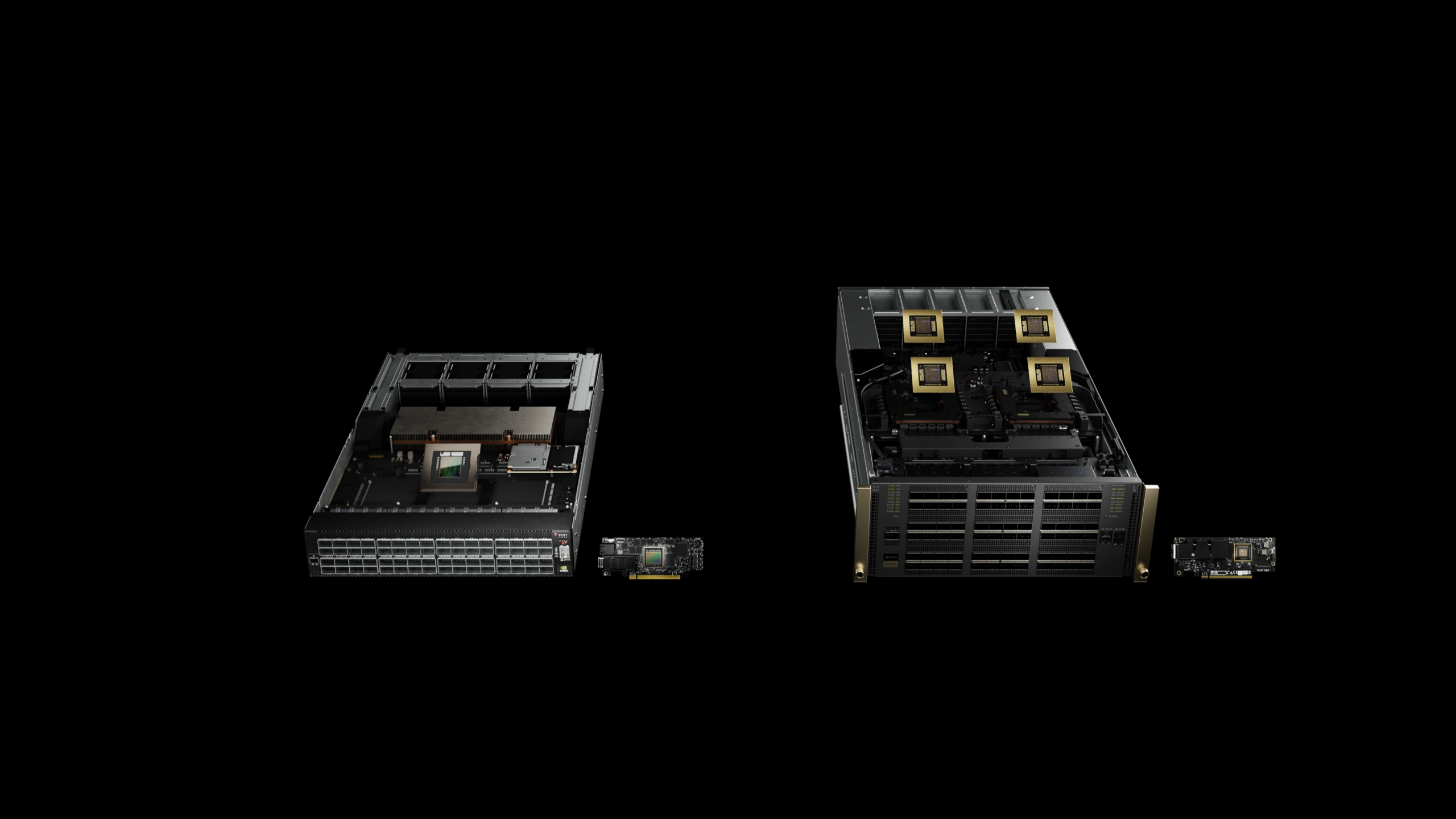

แพลตฟอร์ม NVIDIA Blackwell มาถึงแล้วเพื่อขับเคลื่อนยุคใหม่ของการประมวลผล

Blackwell GPU, NVLink และเทคโนโลยีใหม่ที่มีความยืดหยุ่นเปิดใช้งานโมเดล AI ขนาดล้านล้านพารามิเตอร์ ใหม่ Tensor Cores และ TensorRT- LLM Compiler ลดต้นทุนการดำเนินงานและพลังงานของการอนุมาน LLM ได้ถึง 25 เท่า ตัวเร่งความเร็วใหม่ทำให้เกิดความก้าวหน้าในการประมวลผลข้อมูล การจำลองทางวิศวกรรม การออกแบบอัตโนมัติทางอิเล็กทรอนิกส์ การออกแบบยาโดยใช้คอมพิวเตอร์ และควอนตัมคอมพิวเตอร์ การนำไปใช้อย่างแพร่หลายโดยผู้ให้บริการคลาวด์รายใหญ่ ผู้ผลิตเซิร์ฟเวอร์ และบริษัท AI ชั้นนำทุกราย

NVIDIA เปิดตัว DGX SuperPOD ที่ขับเคลื่อนโดย Blackwell ซูเปอร์คอมพิวเตอร์สำหรับ Generative AI ระดับล้านล้านพารามิเตอร์

ปรับขนาดเป็น Grace Blackwell Superchips นับหมื่นโดยใช้ระบบเครือข่าย NVIDIA ขั้นสูงที่สุด, ซอฟต์แวร์ NVIDIA Full-Stack AI และฟีเจอร์จัดการข้อมูลที่ใช้ Blackwell GPU มากถึง 576 ตัวที่เชื่อมต่อเป็นหนึ่งเดียวด้วย NVIDIA NVLink, NVIDIA System Experts ปรับใช้งานความเร็วสำหรับโครงสร้างพื้นฐาน AI ทันที

NVIDIA เปิดตัวสวิตช์เครือข่ายใหม่ที่ปรับแต่งสำหรับการประมวลผลด้วย GPU ในระดับล้านล้านพารามิเตอร์และโครงสร้างพื้นฐานของ AI

NVIDIA Quantum-X800 InfiniBand สำหรับโครงสร้างพื้นฐานเฉพาะด้าน AI ที่มีประสิทธิภาพสูงสุด NVIDIA Spectrum-X800 Ethernet สำหรับเครือข่ายที่เพิ่มประสิทธิภาพ AI ในทุกศูนย์ข้อมูล NVIDIA Software จัดจำหน่ายคอมพิวเตอร์ Blackwell, สวิตช์ใหม่และ BlueField-3 SuperNICs เพื่อเร่ง AI, การประมวลผลข้อมูล, HPC และเวิร์คโหลดสำหรับคลาวด์

NVIDIA เปิดตัวไมโครเซอร์วิส Generative AI สำหรับนักพัฒนาเพื่อสร้างและปรับใช้ Generative AI Copilots ที่อยู่บนพื้นฐานของ NVIDIA CUDA

ทางเลือกใหม่ของไมโครเซอร์วิส NVIDIA NIM ที่เร่งด้วย GPU และ Cloud Endpoints สำหรับโมเดล AI ที่ได้รับการฝึกล่วงหน้า ได้รับการปรับปรุงให้ทำงานบน GPU ที่เปิดใช้งาน CUDA หลายร้อยล้านหน่วยบนคลาวด์ ศูนย์ข้อมูล เวิร์กสเตชัน และพีซี องค์กรต่าง ๆ สามารถใช้ไมโครเซอร์วิสเพื่อเร่งการประมวลผลข้อมูล, การปรับแต่ง LLM, การอนุมาน, Retrieval-Augmented Generation และ นโยบายจริยธรรมและความรับผิดชอบของการใช้ AI นำมาใช้โดยระบบนิเวศ AI ในวงกว้าง รวมถึง Cadence ผู้ให้บริการแพลตฟอร์มแอปพลิเคชันชั้นนำ, CrowdStrike, SAP, ServiceNow และอื่นๆ อีกมากมาย

SAP และ NVIDIA เร่งการนำ Generative AI มาใช้ในแอปพลิเคชันระดับองค์กรที่ขับเคลื่อนอุตสาหกรรมระดับโลก

ลูกค้าสามารถควบคุมข้อมูลธุรกิจของตนในโซลูชันคลาวด์จาก SAP โดยใช้ LLM แบบกำหนดเองที่ปรับใช้กับบริการ NVIDIA AI Foundry และไมโครเซอร์วิส NVIDIA NIM ใหม่