NVIDIA เปิดตัว H100 NVL dual-GPU AI accelerator ออกแบบมาสำหรับใช้งาน AI ขนาดใหญ่รองรับ Chat-GPT ถือเป็น PCIe dual-GPU ครั้งแรกในรอบหลายปี

NVIDIA เปิดตัว H100 NVL dual-GPU AI accelerator ออกแบบมาสำหรับใช้งาน AI ขนาดใหญ่รองรับ Chat-GPT ถือเป็น PCIe dual-GPU ครั้งแรกในรอบหลายปี

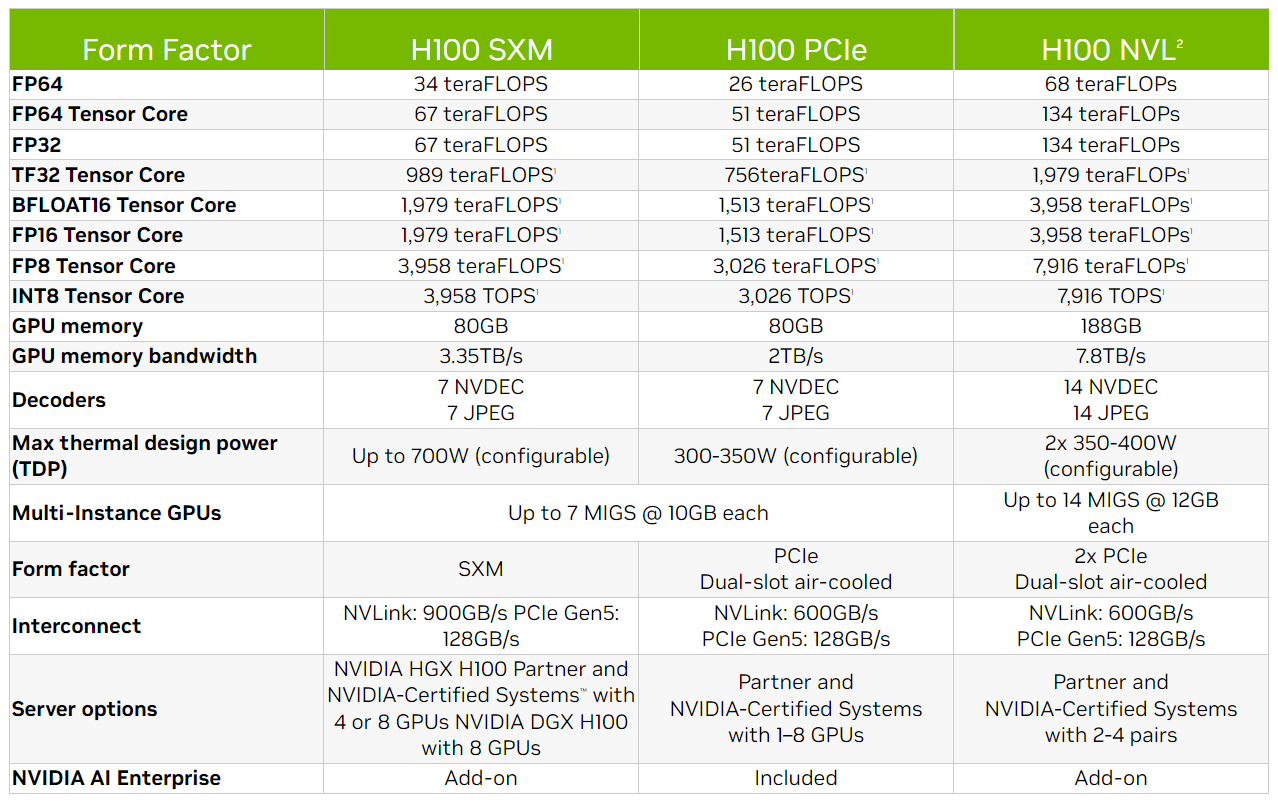

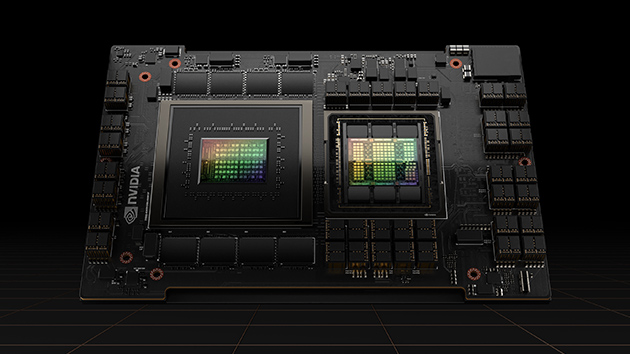

วันนี้ก็มีข่าวจากฝั่ง Nvidia มาอัพเดทให้ทุกท่านได้ชมกันครับกับข่าวของการ์ดจอ H100 NVL dual-GPU AI accelerator ออกแบบมาสำหรับใช้งานโมเดลปัญญาประดิษฐ์ AI ในกลุ่ม Chat-GPT ถือเป็น PCIe dual-GPU ครั้งแรกในรอบหลายปีที่ทาง nvidia ผลิตออกมาโดยไม่ใช่การ์ดจอเกมมิ่ง โดยการ์ดจอ H100 NVL กลุ่มผลิตภัณฑ์ NVIDIA Hopper ที่ออกแบบมาสำหรับการใช้งานในกลุ่ม data-center accelerator ซึ่ง H100 ที่ออกแบบมาโดยใช้งานเพื่อเพิ่มโมเดลภาษา AI language เช่น Chat-GPT สำหรับ NVL ย่อมาจาก NVLink ซึ่งใช้โดยการกำหนดค่านี้บนการ์ด H100 ซึ่ง H100 NVL ไม่ใช่การ์ดจอตัวเดียว แต่เป็นตัวเลือกใช้งานการ์ดจอแบบคู่ dual-GPU ของการ์ด PCIe สองตัวที่เชื่อมต่อกันผ่านบริดจ์ NVLink Gen4 สามตัวนั่นเอง การ์ดจอ H100 NVL มีอินเทอร์เฟซหน่วยความจำ 6144 บิตเต็มรูปแบบ (1024 บิตสำหรับแต่ละสแต็ก HBM3) ที่อัดแรมมากมากถึง 188GB และความเร็วหน่วยความจำสูงสุด 5.1 Gbps ซึ่งหมายความว่าทรูพุตสูงสุดคือ 7.8GB/s ซึ่งมากกว่า H100 SXM ถึงสองเท่า โมเดลภาษาขนาดใหญ่ต้องการบัฟเฟอร์ขนาดใหญ่และแบนด์วิธที่สูงขึ้นย่อมมีผลกระทบมากเช่นกัน

NVIDIA H100 NVL นั้นปรับใช้โมเดลภาษาขนาดใหญ่เหมาะอย่างยิ่งสำหรับการปรับใช้ LLM ขนาดใหญ่ เช่น ChatGPT ในระดับต่างๆ ซึ่งมาพร้อมหน่วยความจำขนาด 94GB พร้อมการเร่งด้วย Transformer Engine ให้ประสิทธิภาพการอนุมานเร็วขึ้นสูงสุด 12 เท่า ที่ GPT-3 เมื่อเทียบกับ A100 รุ่นก่อนหน้าในกลุ่ม data-center โดยทาง Nvidia คาดว่าจะเปิดตัวการ์ดจอ H100 NVL ในช่วงครึ่งหลังของปีนี้